728x90

해당 게시물은 "혁펜하임의 AI DEEP DIVE"를 수강하고 작성되었습니다.

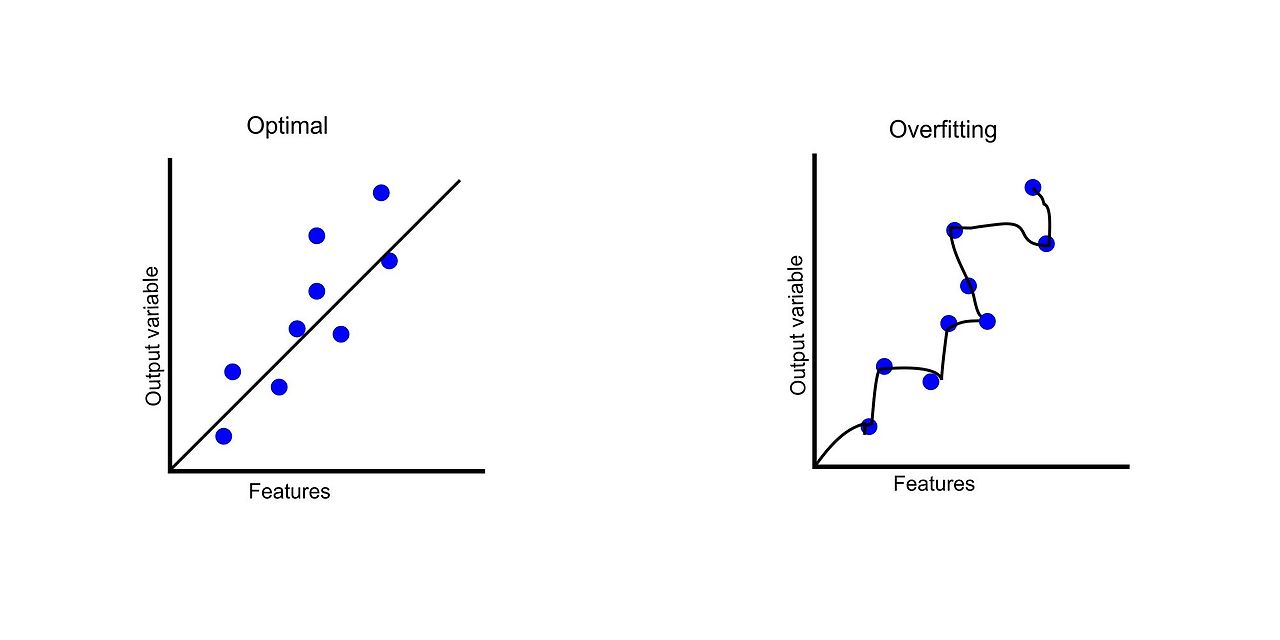

층을 깊게 쌓아 loss 함수를 꼬불꼬불하게 만들면 training data에 대해서는 성능이 좋지만, 보지 못한 데이터가 들어왔을 때 (Test data)는 잘 맞추지 못하게 된다.

이를 어떻게 해결할까?

- 모델이 다시 입력, 출력관의 관계를 단순하게 생각하도록 한다. (Dropout)

- Data Augmentation

Data Augmentation은 학습 데이터가 너무 적어서 생기는 overfitting 문제를 해결해준다.

Data Augmentation은 데이터를 변조, 변형시켜서 데이터 우려먹기가 가능하다!

728x90

'AI' 카테고리의 다른 글

| Regularization (Overfitting 방지 방법) (0) | 2024.09.10 |

|---|---|

| Overfitting 방지를 위한 Dropout (1) | 2024.09.09 |

| Loss Landscape, Skip connection (0) | 2024.09.09 |

| Batch Normalization, Layer Normalization, Vanishing Gradient 해결 방안 정리 (0) | 2024.09.09 |

| ReLU (Rectified Linear Unit) (0) | 2024.09.06 |