728x90

해당 게시물은 "혁펜하임의 AI DEEP DIVE"를 수강하고 작성되었습니다.

정답을 알고 있는 데이터가 너무 적을 때 사용할 수 있는 학습 방법이 "자기지도 학습"이다.

자기지도 학습은 원래 풀려고 했던 문제 말고 다른 문제(어느정도 도움을 주는 문제)를 먼저 풀게끔 하는 방식이다.

데이터 안에서 자기 스스로 정답(lable)을 만들기 때문에 자기지도 학습 이라고 명칭한다.

- 먼저 풀게끔 하는 문제 (pretext task)학습으로 pre training을 시킨다.

- downstream task를 풀기 위해 pre training 시킨 모델의 출력층을 downstream task에 맞는 출력층으로 바꾸어, 적은 량의 정답을 알고 있는 데이터로 다시 training을 시키면... 내가 원했던 classification 모델이 완성된다.

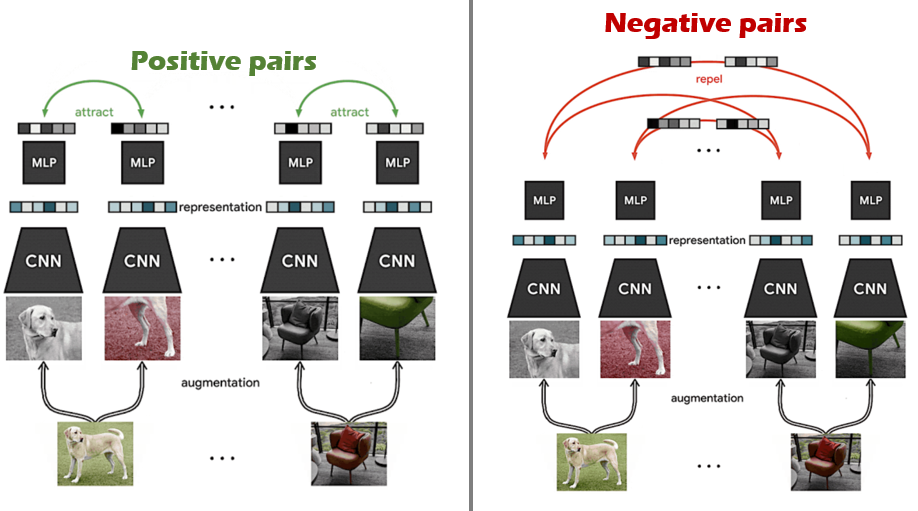

강아지 사진의 일부를 떼어서 두 장을 만든다. 출처가 같은 두 장의 사진을 각각 CNN 모델에 통과시키면, 이 두 결과물은 값이 비슷해야 할 것이다.

출처가 같은 사진의 두 패치의 출력 결과가 비슷하게(attract) 만들자!

출처가 다른 두 패치의 출력 결과가 값이 멀어지도록(repel) 만들자!

이렇게 학습시키는 것이 Contrastive learning이다.

해당 방법론으로 사진 한장을 엄청나게 우려먹을 수 있다.

728x90

'AI' 카테고리의 다른 글

| 인공신경망, weight, bias (0) | 2024.08.31 |

|---|---|

| 강화 학습 (0) | 2024.08.31 |

| 지도 학습 vs 비지도 학습 (0) | 2024.08.31 |

| CNN, RNN, GAN (0) | 2024.08.31 |

| Artificial Intelligence vs Machine Learning vs Deep Learning (0) | 2024.08.31 |